Read this article in English ![]()

La Montée En Puissance Du CI/CD

Dans Le Monde De L’Analytics

Où Se Situe Le Dernier Kilomètre Sur Le Parcours De Vos Données ?

Le dernier kilomètre du parcours des données dans les organisations est un concept populaire mais aussi galvaudé. Où se situe exactement le dernier kilomètre ? Nous avons l’habitude de lire des blogs ou autres livres blancs édités par des experts de la donnée mettant en avant l’importance de la qualité et de la fiabilité des données qui seront consommées ultérieurement par d’autres systèmes ; ce qui constitue effectivement le socle d’une bonne culture des données en entreprise. Cependant, chez Wiiisdom, nous pensons que le dernier kilomètre est celui où la donnée est effectivement livrée au consommateur, pour prendre l’image du consumérisme, c’est à dire là où les décideurs se connectent pour consommer la donnée et prendre des décisions : la couche BI ou décisionnelle.

Pour avoir des données gouvernées et fiables dans le tout dernier kilomètre du voyage des données, il faut pouvoir assurer la qualité des Analytics, et cela nécessite des méthodologies agiles comme le CI/CD. Les organisations ont avec le temps changé leurs organisations qui étaient très dépendantes de l’IT pour ce qui concernait la BI en encourageant un modèle dit du libre-service. De nos jours, les entreprises favorisent une culture de la donnée afin que n’importe quel utilisateur puisse mener ses analyses et ce, grâce à des technologies qui nécessitent très peu de formation. Cependant, le taux d’adoption reste cantonné à 30%. Comment les entreprises peuvent-elles remédier à cette situation et fournir des analytics fiables à la vitesse de l’entreprise ? Cela m’amène à la partie suivante.

Un Manque De Considération Pour La Couche Analytique

Il est vrai qu’aujourd’hui, les fournisseurs de solutions de BI et Analytics à l’image de Tableau et Microsoft rendent leur plateforme de plus en plus accessible aux personnes non-expertes et consomment de plus en plus de données provenant de sources de plus en plus nombreuses. Et, oui, des concepts comme le DataOps aident à rendre les données plus fiables, mais ces technologies seules, ne suffisent pas à assurer la qualité des données de bout en bout. La couche analytique est en fait une couche comportant une multitude de sous-composants, par exemple Tableau + les sources de données ou Power BI + requête de données, et il y a donc encore plus d’éléments pouvant impacter la donnée, ce qui accroit le besoin de contrôle qualité. La liberté de tout le monde de pouvoir se connecter à tout s’accompagne de trois problèmes principaux :

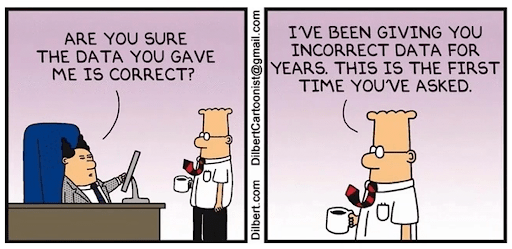

1. La confiance dans les Analytics

Le manque de contrôle de la part de l’informatique et, par conséquent, l’absence d’une sorte de méthodologie, amèneront les utilisateurs à se demander s’ils peuvent faire confiance aux données qu’ils consomment au travers des Analytics. S’il n’y a pas de méthodologie en place pour tester et valider les analyses, comment les utilisateurs peuvent-ils prendre de bonnes décisions en toute confiance ?

2. L’adoption utilisateur

Le taux d’adoption de la BI est malheureusement bloqué à 30% en raison du manque de formation et de confiance, et des multiples points d’entrée des données dans une entreprise. Il appartient à chaque organisation de former ses employés à l’utilisation de l’analytique, d’améliorer leur connaissance des données et de mettre en œuvre les bonnes technologies pour garantir la meilleure expérience utilisateur.

3. Les risques

De nos jours, de nombreuses organisations sont axées sur les données et prennent des décisions stratégiques sur la base de leurs analyses. Si les analyses ne sont pas gouvernées et ne sont pas fiables, et que rien n’est fait, les conséquences peuvent être désastreuses pour l’entreprise. L’automatisation des processus robotiques (RPA) accentue les risques avec des actions traitées automatiquement sur la base de données potentiellement erronées.

Afin d’éviter ces problèmes de confiance, d’adoption et de risque, les organisations doivent mettre en œuvre des solutions pour accroître la qualité et la gouvernance des analytics. Pour cela, il faut agir à grande échelle et la seule façon d’y parvenir est de mettre en œuvre des méthodologies agiles comme le CI/CD.

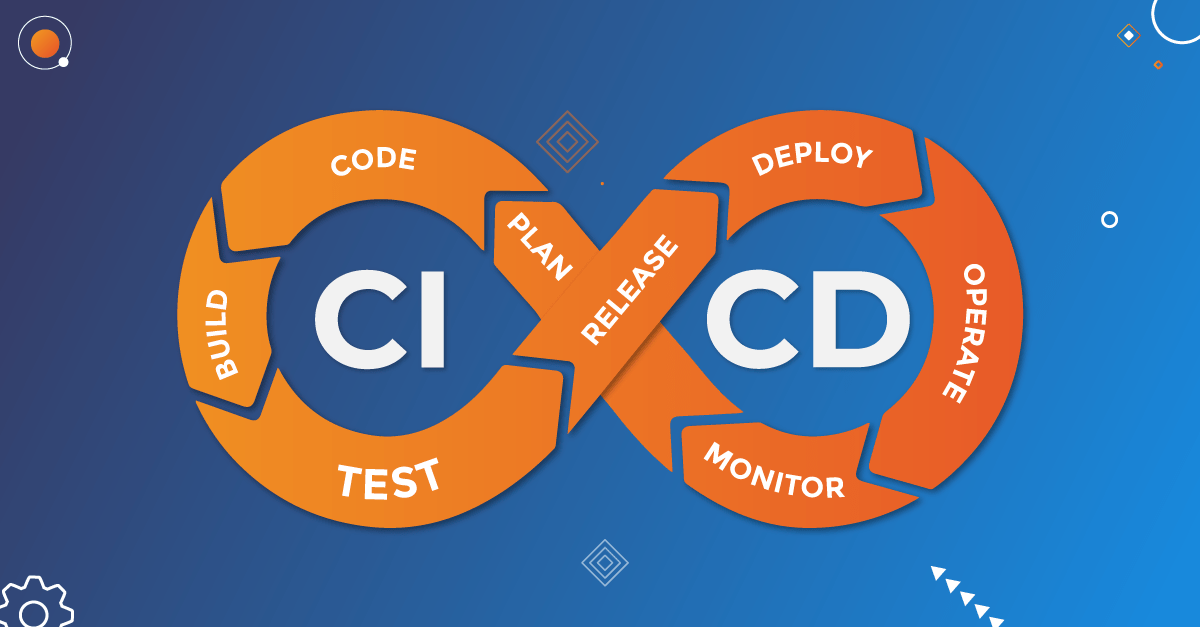

L’approche CI/CD appliquée à l’analytique : explications

Ce qui était auparavant du ressort de l’informatique est maintenant devenu quelque chose où tout le monde peut tout faire, mais à cause de cela, le problème de la confiance, de l’adoption et du risque a augmenté. Les équipes d’analystes ont toujours besoin que le contenu soit fourni plus fréquemment et plus rapidement et qu’il soit livré avec moins ou pas de problèmes. Les entreprises ne peuvent pas simplement arrêter le libre-service pour cette raison, mais plutôt s’efforcer de créer un équilibre entre les utilisateurs qui sont libres de faire leurs propres manipulations et les informations qui sont centralisées et poussées vers les clients. Ces informations doivent être gérées et diffusées rapidement, et pour cela, il faut des méthodologies agiles et de l’automatisation. Celles-ci vous permettront de :

- Scaler vos initiatives BI et Analytique

- Réduire les coûts d’exploitation et le coût total de possession

- Accélérer les livraisons et augmenter la satisfaction des utilisateurs.

- Réduire le temps de réparation et limiter les risques.

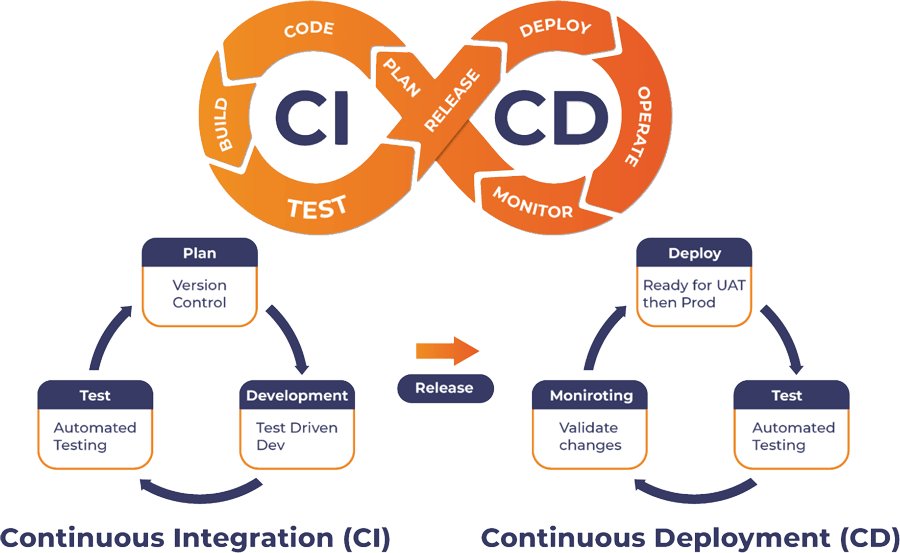

Par exemple, pour aider les entreprises dans ce domaine, Tableau a lancé le Tableau Blueprint afin de fournir aux organisations un framework pour devenir agiles et axées sur les données. Dans ce cadre, Tableau affirme que “l’agilité d’une organisation est définie par des processus reproductibles qu’elle a mis en place”. Pour ce faire, le meilleur point de départ est de s’inspirer de ce qui a été par ailleurs pour d’autres logiciels comme le DevOps et le DataOps et l’appliquer aux logiciels de BI et Analytics : l’AnalyticsOps. C’est là que l’intégration continue (CI et le déploiement continu (CD) entrent en jeu.

Le CI/CD vous permet d’établir des process pérennes “si ça marche aujourd’hui, ça continuera de marcher demain”. Elle vous oblige à effectuer des tests continus. Par exemple, vous développez, vous testez tout avant de livrer, puis vous répétez ce processus si nécessaire. La mise en place de méthodes de développement piloté par les tests (TDD) est encore plus efficace, car vous savez quels sont les critères de réussite avant la mise en production. Une fois que vous avez testé et mis en production, il est fondamental de surveiller et de monitorer en permanence les tableaux de bord. Cela permettra aux développeurs de trouver les erreurs avant les utilisateurs et de les corriger rapidement. L’automatisation est une nécessité pour le CI/CD et nos solutions le permettent :

3 cas concrets d’utilisation du CI/CD appliqués à l’analytique

Pour bien comprendre comment les processus CI/CD permettent à votre organisation d’être agile, voici trois exemples de ce qui peut être mis en place :

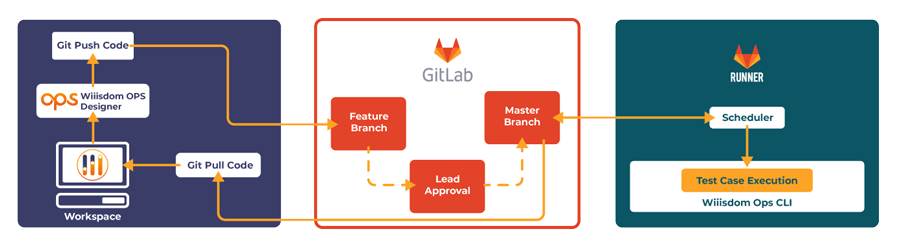

Exploiter l’automatisation chez Red Hat pour son CI/CD

Notre client, Red Hat, exploite à son plein potentiel l’automatisation en planifiant, construisant, testant, puis en mettant en production, uniquement si tout est correct. Cela leur permet d’avoir des mises à jour plus rapides des scénarios de test et la possibilité de planifier les scénarios de test à leur convenance.

Mise en oeuvre du CI/CD chez Red Hat avec les solutions Wiiisdom

Déploiement plus rapide chez Unite Us grâce au CI/CD

Un autre client, Unite Us, utilise également le CI/CD. Ils développent, testent sur une plateforme de développement, puis une fois qu’ils sont prêts à publier, un webhook appelle automatiquement Wiiisdom Ops. La version est placée dans un environnement de test où Wiiisdom Ops effectue une longue série de tests. Une fois que tout est en ordre, elle est envoyée en production où Wiiisdom Ops effectue d’autres tests finaux. Le passage de développement à test et de test à production se fait automatiquement sans aucune intervention manuelle, ce qui permet à Unite Us de publier rapidement des tableaux de bord Tableau à ses clients.

Mise en œuvre du CI/CD dans la couche sémantique

Et enfin, vous pouvez mettre en place un système CI/CD pour chaque mise à jour de la couche sémantique. Prenons le cas d’un utilisateur qui pour une raison ou une autre, voudrait ajouter quelques données de vente à son tableau de bord. Il prendrait l’objet existant du chiffre d’affaires, utiliserait GIT ou tout autre solution de versionning, apporterait les modifications nécessaires (sans oublier de réaliser des tests) et s’assurerait ensuite que tout fonctionne et que rien ne soit impacté. Vous comprenez bien que les utilisateurs ne peuvent pas faire cela manuellement à chaque fois qu’une modification doit être apportée dans l’environnement de développement. Ensuite, une fois que tout est prêt coté développement, il est temps de le pousser en production. Là encore, des tests doivent être exécutés en production pour s’assurer que tout fonctionne. Cette méthode n’est pas viable. L’avantage d’utiliser une solution de test telle que Wiiisdom Ops est que les tests que vous avez créés dans le CI peuvent être réutilisés exactement de la même manière dans le CD, ce qui vous permet de mettre en place un processus reproductible à l’infini.

Prêt à travailler votre agilité analytique ?

Le succès de l’analytique nécessite des méthodologies agiles telles que le CI/CD pour permettre un retour sur investissement plus rapide et garantir des données fiables et gouvernées. En utilisant des solutions de test automatisées, les organisations peuvent augmenter la confiance, l’adoption et l’expérience utilisateurs. Si vous souhaitez en savoir plus sur la façon de mettre en œuvre des méthodologies agiles pour votre plateforme BI et Analytics, contactez-nous dès aujourd’hui.